一项名为 Linear-MoE 的新技术,将线性序列建模与混合专家模型相结合,有望提升大型语言模型的效率。

在大型语言模型(LLMs)飞速发展的浪潮中,如何平衡模型的性能与计算效率一直是研究的重点。 近日,一项名为 Linear-MoE 的新技术引起了学术界和业界的关注。 这项技术创造性地将线性序列建模(Linear Sequence Modeling)的思想与混合专家模型(Mixture-of-Experts, MoE)的架构相结合,为构建更高效、更强大的 LLMs 提供了新的思路。

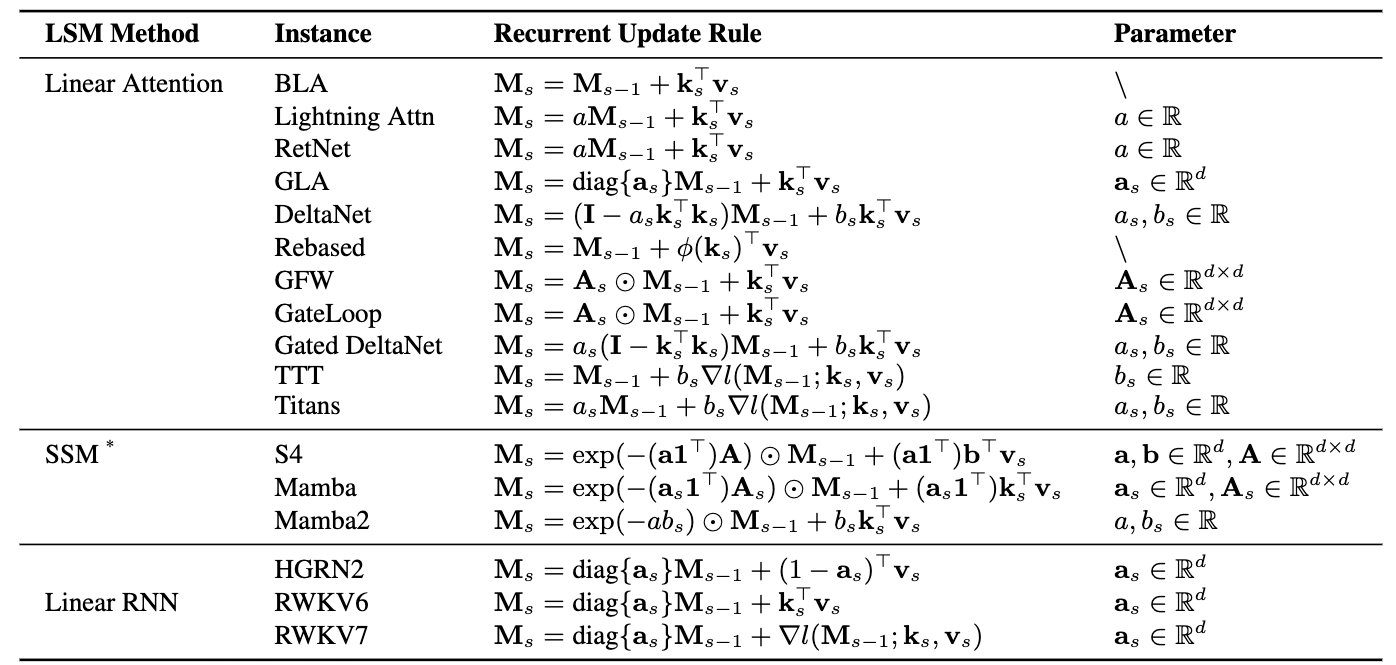

传统的 Transformer 模型在处理长序列时面临计算量大的挑战。 而 MoE 模型虽然通过稀疏激活提高了计算效率,但在不同的专家之间仍然存在协调和路由的问题。 Linear-MoE 的创新之处在于

- 引入线性序列建模 利用线性模型的特性,简化序列处理过程,降低计算复杂度。

- 结合 MoE 架构 保留 MoE 模型通过稀疏激活提升效率的优势。

- 优化专家路由 可能通过线性的方式更有效地进行专家选择和路由。

这种结合,旨在发挥线性模型在处理序列时的效率优势,同时利用 MoE 模型在处理复杂任务时的并行性和容量优势,从而构建出既高效又强大的语言模型。

兼顾效率与性能 LLM 发展的新方向

Linear-MoE 的核心目标是提升大型语言模型的效率和性能。

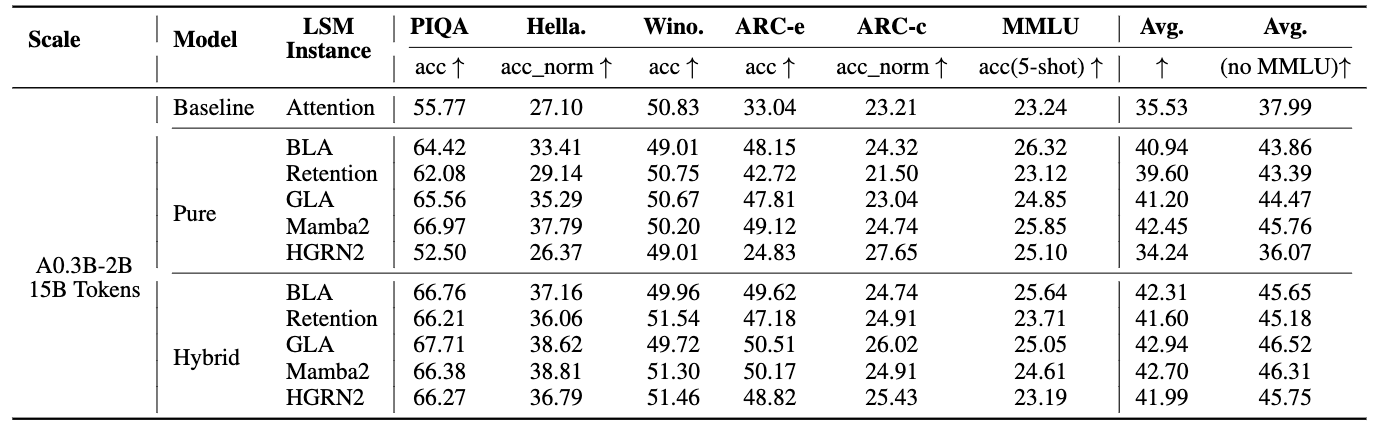

从参考资料来看,Linear-MoE 在以下方面展现出潜力

- 计算效率提升 线性模型的引入有望降低处理长序列时的计算负担,从而降低训练和推理成本。

- 模型性能提升 通过 MoE 架构,模型可以更好地学习和处理不同类型的任务和数据。

- 潜在的可扩展性 这种架构可能更容易扩展到更大的模型规模。

Linear-MoE 的出现,为大型语言模型的未来发展提供了新的可能性,有望在保持甚至提升模型性能的同时,显著提高计算效率,这对于 LLMs 的广泛应用至关重要。

开源项目支持 社区共同推动发展

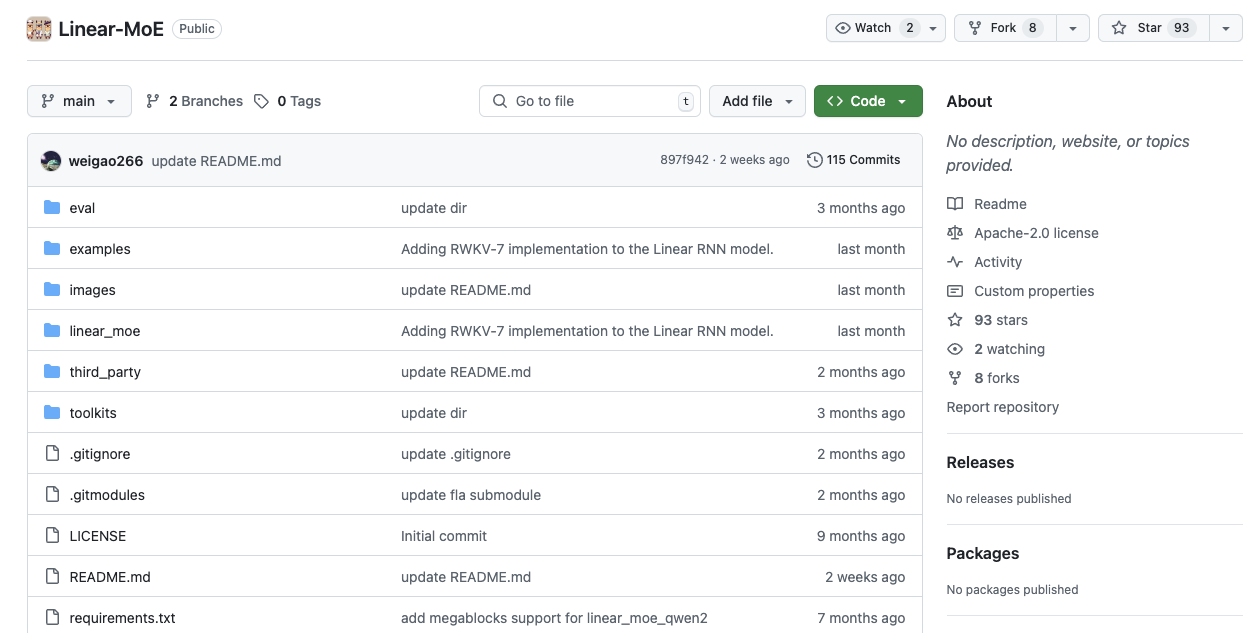

Linear-MoE 技术并非停留在理论阶段,它已经作为一个开源项目在 GitHub 上发布。

开源项目的存在,意味着更多的研究人员和开发者可以参与到 Linear-MoE 的研究、开发和应用中来。 这种社区驱动的模式,将有助于加速 Linear-MoE 技术的迭代和完善,推动其在实际应用中的落地。

Linear-MoE 的提出,是大型语言模型架构探索中的一次重要尝试。 它将线性序列建模和 MoE 的优点结合起来,旨在解决当前 LLMs 面临的效率瓶颈。 随着开源社区的共同努力,Linear-MoE 有望成为未来构建高效、强大语言模型的一个重要方向。

相关推荐

2025 AI 技术峰会

AI 实战课程

热门工具

AI 助手

智能对话,提升效率

智能图像处理

一键美化,智能修图

AI 翻译

多语言实时翻译

评论 (0)

暂无评论,快来发表第一条评论吧!